Je ne peux pas sembler trouver des informations sur la détermine Google si vous êtes C'est en relation avec cette question sur Capitales de l'URL légitime pour le référencement . Si le contenu textuel est exactement le même, mais le rendu est différent (HTML HTML de 1995. Style HTML vs Ajax vs Flash), est-il vraiment un problème avec le cloaking?

Merci pour votre mise sur celui-ci.

7 Réponses :

Google regarde votre site lors de la présentation de l'agent utilisateur, autre que GoogleBot.

Ils font? Et cet autre utilisateur-utilisateur s'identifie-t-il toujours comme une sorte de robot? Sinon, cela ne serait-il pas très sournois sur la part de Google?

Même des agents d'utilisateur différents ne peuvent pas aider Google Dites à SI un navigateur a utilisé l'index Z pour superposer un DIV pour masquer certains contenus de View - Est-ce que cela qualifie de "cloaking"?

@JDK: Google a créé un navigateur avec un moteur de rendu. Ils pouvaient très bien dire.

Ok alors, c'est un peu ce que j'ai posté ci-dessous comme une solution - je n'étais pas sûr si ma compréhension répondait vraiment à la définition du cloaking, mais il semble que cela soit suffisamment proche.

@Thilo: sournois? Je suppose que différentes personnes ont des prises différentes, mais je pense que ça va jusqu'à ce qu'ils respectent les robots.txt

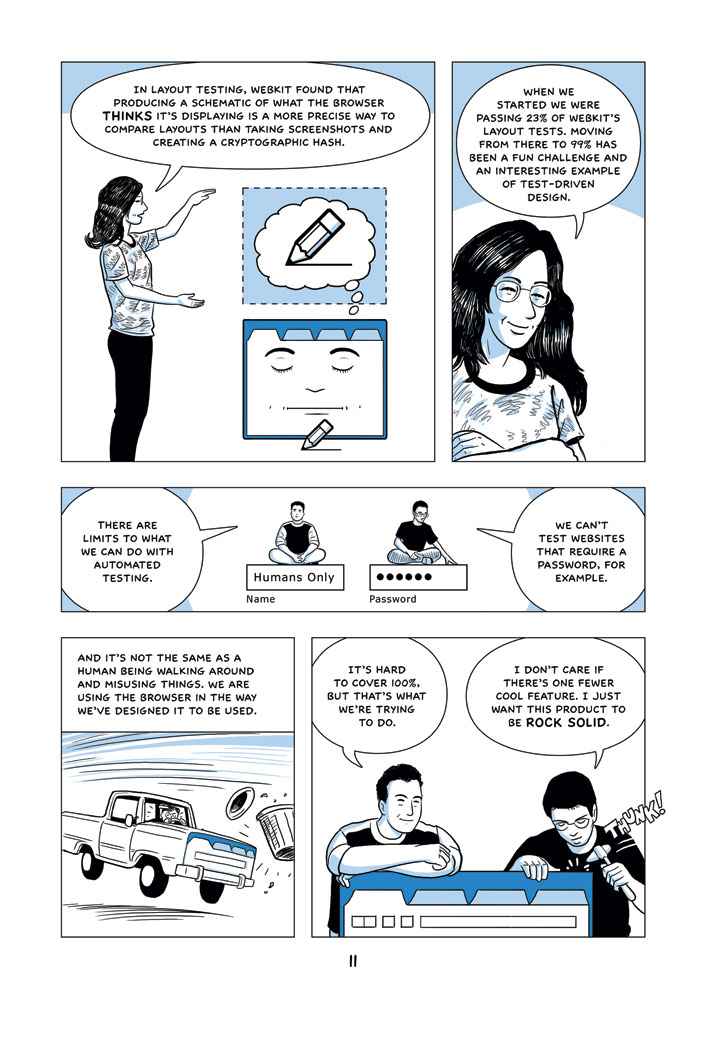

Voir le Google Chrome Comic Book Page 11 où il décrit (même mieux que les termes de layman) sur la manière dont un outil Google peut prendre un schéma d'une page Web. Ils pourraient utiliser cette technologie ou une technologie similaire pour l'indexation de la recherche Google et la détection de cape - au moins ce serait une autre bonne utilisation pour cela.

Pouvez-vous expliquer un peu comment cela (qui concerne les tests automatisés d'un moteur de rendu) concerne la détection de cape?

Je pense que la technologie de spéculation pourrait être reconditionnée comme "ce que le navigateur pense qu'il affiche" et appliqué à ce que le GoogleBot gratte réellement. Il ne serait pas différent de Testswarm pour JQuery testswarm.com mais Google utiliserait des fermes de serveurs pour cela. Yah, c'est là-bas mais il a des lambeaux de viabilité.

Mon explication n'est probablement pas très claire, mais je dis essentiellement si Google (via Chrome) peut créer une technologie qui démontre une différence entre ce qu'un navigateur Web «pense» qu'il voit et ce qui est réellement vu, alors l'idée n'est pas infaisable qu'ils Peut également avoir d'autres technologies comparant la "réflexion" vs "Voir" World Web.

Autant que je sache, comment Google prépare les résultats du moteur de recherche est secreté et en constante évolution. Spoofing Différents agents utilisateur est facile, ils pourraient donc le faire. Ils pourraient également, dans le cas de JavaScript, réellement rendu des pages partielles ou entières. "Ont-ils une équipe d'êtres humains comparant?" C'est douteux. Beaucoup a été écrit sur les stratégies d'analyse de Google, notamment Ce , mais si les humains sont impliqués, Ils sont seulement appelés dans des cas spécifiques. Je doute même ceci: toute personne-puissance dépensée est probablement dépensée en modifiant le moteur rampant.

En réalité, de nombreux algos de Google sont trivialement inversés et sont loin de la science de la fusée. Dans le cas de la "détection de la classique", toutes les suppositions précédentes sont sur l'argent (en dehors de, quelque peu ironiquement, John K lol) si vous ne me croyez pas configurant certains sites de test (entrées) et certains ' Cas de test de clohaling '(d'autres entrées), soumettez vos sites à oncle Google (traitement) et testez vos non-hypothèses via des perceptions quantiques cognitives cognitives pseudo-avancées humaines (<- BTW, j'ai réalisé cela pour une valeur de divertissement (et Maintenant, je nie des parenthèses pour vraiment gâcher votre esprit :)) aka "Vérification de Google Resuts Pour voir si vous êtes déjà interdit" (sorties). Boucle jusqu'à ce que l'illumination == true (noob!) Lol

Google embauche des entrepreneurs (indirectement, par l'intermédiaire d'une agence extérieure, pour un salaire très bas) pour examiner manuellement les documents retournés comme résultats de recherche et juger leur pertinence pour les termes de recherche, la qualité des traductions, etc. Je doute fort que c'est leur seul outil de détection de cloaking, mais c'est l'un d'entre eux.

Un test très simple serait de comparer la taille du fichier d'une page Web de la scie Googlbot contre la taille de fichier de la page numérisée par un utilisateur alias de Google qui ressemble à un utilisateur normal.

Cela détecterait la plupart des candidats suspects pour un examen de la plus simple.

Ils appellent votre page en utilisant des outils tels que CURL et ils construisent un hachage basé sur la page sans l'agent utilisateur, puis ils construisent un autre hachage avec l'agent utilisateur GoogleBot. Les deux hachages doivent être similaires, ils ont des algorithmes pour vérifier les hatupes et savoir si son cloaking ou non

Techniquement, vous répondez est correct, mais il serait préférable de fournir des liens sur les informations que vous avez fournies pour améliorer la qualité de cette réponse.

Vote à proximité comme hors sujet: migrer vers webmasters.se!